Evaluation for transitions

mercredi 15 janvier 2025

How transitions change evaluations, and how evaluations can help transitionss

3 articles – 15 novembre 2020 – n°1

3 articles – 15 novembre 2020 – n°1Plongée en pleine guerre froide avec la Realpolitik de l'évaluation, des idées pour professionnaliser l'évaluation, et oldiesbutgoodies, de quoi se demander ce que les évaluateurs et les évaluatrices défendent dans leur métier... C'est le sommaire de ce numéro 1.

Ouvrage collectif rédigé sous la direction de Markus Palenberg et Arne Paulson1, ce livre vise à répondre à deux questions qui animent depuis longtemps la communauté des évaluateurs/trices : qu’est-ce qui explique le décalage fréquemment observé entre demande et offre d’évaluation et quelles solutions peuvent être mises en œuvre pour réduire cet écart ?

Le premier mérite de l’ouvrage est de fournir une description fine des principaux facteurs expliquant les relations souvent décevantes entre offre et demande d’évaluation. Si les explications sont souvent connues (décalage temporel entre la réalisation des évaluations et la prise de décision, place centrale des compétences des commanditaires et des équipes d’évaluation, manque de ressources…), elles sont mises en lumière dans des contextes nationaux variés (France, Irlande, Italie, Norvège…).

Au risque d’être accusé de chauvinisme, ce qui serait presque entendable pour un livre sur la Realpolitik, on recommande la lecture du chapitre de notre collègue Agathe Devaux-Spatarakis sur l’essor de la méthode expérimentale par assignation aléatoire en France, qui permet d’illustrer un cas de double « piratage » des évaluations, par l’offre et la demande.

Plusieurs pistes sont mises en avant pour faciliter le dialogue entre offre et demande d’évaluation. Nous décrivons brièvement deux des solutions qui nous ont le plus intéressées.

La première consiste à investir spécifiquement dans l’organisation de l’évaluation, en confiant l’animation du dialogue entre offre et demande d’évaluation à un acteur intermédiaire. C’est le rôle qui a été confié à l’agence nationale de la recherche en Norvège, dans le cadre de l’évaluation de la réforme des soins de santé initiée en 2012 et qui a permis une meilleure compréhension des attentes des différentes parties (le ministère de la Santé et les centres de recherche en charge de l’évaluation) (voir le chapitre 6 d’Olaf Rieper2).

La deuxième piste nous invite à réfléchir à la faible place accordée aux sciences sociales en évaluation (voir le chapitre 10 de Sebastian Lemire, Christina Christie et Steffen Bohni Nielsen3). Ces auteurs/rices militent ainsi pour renforcer l’intégration des théories des sciences sociales dans les théories des programmes et ainsi promouvoir une approche d’imbrication théorique (theory knitting):

La position que nous défendons est que nous devons nous diriger plus fermement vers une imbrication des théories – en ayant recours de façon transparente et systématique aux théories des sciences sociales dans la pratique de l'évaluation. En agissant ainsi, nous rendons nos théories de programmes plus spécifiques et renforçons leur capacité à être testées et généralisées. In fine, nous favorisons le recueil de preuves crédibles et exploitables.

Comme le souligne en conclusion R. Pablo Guerrero4, cet ouvrage révèle les failles observées au sein de la communauté de l'évaluation entre offre et demande et donne à voir deux mondes qui se connaissent et s’ignorent à la fois :

Que ce soit du côté de la demande ou de l’offre, on observe des intérêts spécifiques. En l’absence d’une compréhension claire des objectifs sous-jacents de chaque groupe, la demande et l'offre ne pourront se recouper que dans un espace abstrait.

Ce constat soulève deux questions pour l’avenir :

Lire la table des matières et la 4e de couverture ici.

Palenberg, M. Paulson, A. (ed.) (2020). The Realpolitik of Evaluation. Why Demand and Supply Rarely Intersect. Routledge.

Les « compétences » et la « professionnalisation » font l’objet de conversations et de recherche dans les sphères d’évaluation déjà depuis un certain moment. Vous avez peut-être par ailleurs remarqué la création du nouveau groupe de « reconnaissance professionnelle des compétences » à la SFE, qui s’est réuni pour la première fois le 14 octobre 2020.

Cela semble ainsi un moment propice pour discuter de l’article publié par Benoît Gauthier, Une analyse engagée de la professionnalisation des pratiques d’évaluation. « Engagée », en effet, car M. Gauthier considère que la professionnalisation permet de contribuer à une meilleure performance de l’évaluation et de protéger le public, qui autrement « n’est pas en mesure de juger de la qualité de cette performance » (p.130).

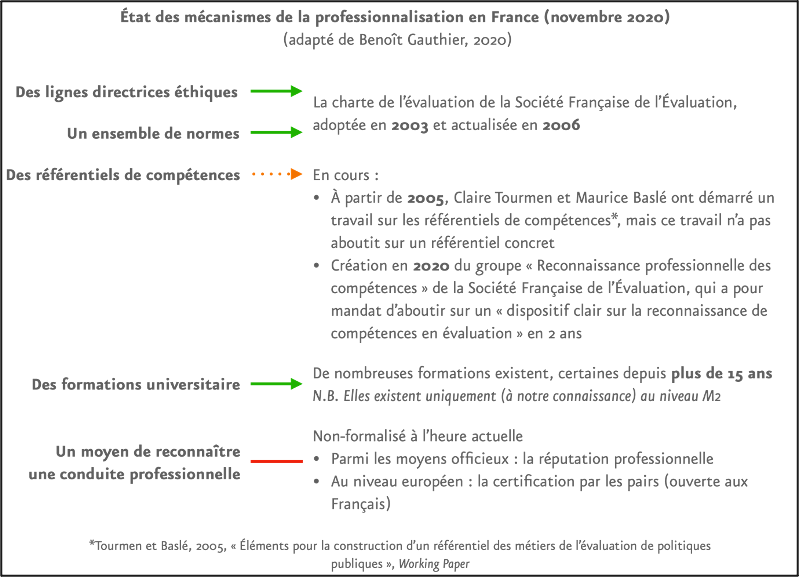

Il précise que la professionnalisation d’un métier comporte de nombreux « ingrédients », dont, selon lui, cinq mécanismes clés, qui peuvent fournir un bon moyen de rendre compte de la professionnalisation dans différents pays. La Figure ci-dessous résume notre interprétation de l’état actuel des mécanismes de la professionnalisation en France : s’il existe déjà des lignes directrices éthiques, des normes et des formations universitaires (et ce depuis près plus d’une quinzaine d’années), les référentiels de compétences ne sont pas encore formalisés, ni un moyen de reconnaître une conduite professionnelle.

À quoi ces deux derniers mécanismes peuvent-il servir ?

Un référentiel de compétences permet, entre autres, aux évaluateurs/rices d’avoir une feuille de route de compétences qu’ils doivent entretenir et améliorer tout le long de leur carrière.

Le moyen de reconnaître une conduite professionnelle va encore plus loin, dans la mesure où il encadre la conduite professionnelle et permet même de sanctionner les praticien·nes si nécessaire. Nous avons déjà entendu parler de sanctions, souvent très médiatisées, que les conseils de discipline peuvent infliger lors d’une faute professionnelle grave : de dentistes qui massacrent leurs patients ou des chirurgiens qui réalisent des opérations médicalement non-nécessaires … si ces fautes entraînent souvent des poursuites judiciaires, les conseils de discipline existent également pour faire en sorte que ces professionnels ne puissent plus exercer leur métier sur le territoire français. Bon gré, mal gré, nos évaluations ont rarement des effets aussi immédiats sur nos concitoyens qu'une opération ratée, mais il ne faut pas sous-estimer l’impact d’une « mauvaise » évaluation ou d'un mauvais professionnel, et les effets que cela peut entrainer sur notre réputation ou sur la façon dont les acteurs voient l’évaluation par la suite.

De toute façon, il n’est pas question de simplement « acter » ces mécanismes : chaque mécanisme peut être très conflictuel, dans la mesure où il entraîne nécessairement un travail de normalisation au profit ou détriment de certain·es - comment qualifierons-nous une « bonne » ou « mauvaise » évaluation, par exemple ? C’est pour cette raison que M. Gauthier conclut son article avec un exposé des nombreux bénéfices et risques de la professionnalisation : l’amélioration de la formation en évaluation et des connaissances, permettant aux professionnels émergents de trouver plus facilement une place dans la profession ; et à l’inverse, l’exclusion de praticiens talentueux si des barrières à l’entrée deviennent excessives.

En somme, les discussions sur la professionnalisation sont aussi riches qu’elles sont sources de tension. Nous restons toutefois optimistes et espérons ces démarches permettront de tirer tout le monde vers le haut.

Voir aussi l’entretien de Colette Lanson avec Benoît Gauthier concernant les pratiques d’évaluation au Canada.

Gauthier, B. (2020). Une analyse engagée de la professionnalisation des pratiques d’évaluation. 11. doi (librement téléchargeable)

Pensez-vous qu'une évaluation doit apporter une vision objective et factuelle des situations analysées, ou au contraire qu'elle doit défendre certains intérêts, et par conséquent assumer une dimension de plaidoyer ? Il y a 20 ans déjà, Jennifer Greene nous invitait à ne pas se mentir et à se rendre compte que toute évaluation défendait une cause, qu’elle soit explicite ou implicite. C'est en ce sens que Greene écrit que la dimension de plaidoyer (advocacy) est inévitable dans une évaluation. Bien consciente que cette assertion déroutante puisse être considérée comme une hérésie par bon nombre d’évaluateur/rices, son raisonnement peut aider un certain nombre de lecteurs à se forger une opinion sur la question.

En effet, pour elle, l’ensemble des choix que nous faisons au cours du processus évaluatif sont imprégnés de valeurs : le choix des questions, les choix des critères, le choix des points de vue à collecter, le choix des méthodes, le choix des personnes qui participent au processus, et ainsi de suite. Greene souhaite ainsi désamorcer la confusion qui peut naître du mot plaidoyer, qui n’est pas selon l’autrice le fait d’être ami ou ennemi d’une politique publique, ni de biaiser son analyse en conséquence.

Reconnaître la dimension de plaidoyer de nos évaluations, c’est accepter d’être les « défenseurs d’une cause », que Greene nous enjoint de préciser en répondant aux questions suivantes : quels intérêts et valeurs l’évaluation met-elle en avant ? Et plus concrètement : à quelles questions et à quels critères jugeront nous la politique, et lorsque nous y répondront, que défendons-nous, et pour qui ? L’autrice souligne que la réponse à ces questions devrait être explicite dans les évaluations.

Parmi ses exemples, Greene évoque dans l’article une évaluation réalisée dans un contexte marqué par des conflits de valeurs importants. Le principal sujet de discorde est le changement d’un programme qui passe de deux niveaux préparatoires à l'université (un niveau élevé et un niveau moyen) à un seul, dans lequel sont regroupés des étudiants ayant des niveaux de réussite variés. Les opposants à ce changement sont convaincus que les étudiants ayant un niveau élevé n'apprendront pas assez pour réussir à entrer dans des universités sélectives. À l’inverse, les partisans de ce changement soulignent les avantages éducatifs et sociaux que retireront les étudiants en travaillant avec davantage de diversité raciale, ethnique et de genre dans leur réussite.

Positionner l'évaluateur comme étant désengagé et éloigné des conflits de valeurs dans ce contexte, comme prétendre que l’unique valeur qui guide l’évaluation est l'objectivité, reviendrait à rater le coche : « nous manquerions de sincérité, voire tromperions nos lecteurs et destinataires de l’évaluation ». Greene explique avoir souhaité au contraire dans cette évaluation défendre publiquement « le pluralisme démocratique » et veiller à ce que le débat soit permanent en incluant des voix et perspectives multiples. C’est ici que réside pour Greene sa posture d’évaluatrice « engagée ». Greene plaide ici pour que l’évaluation offre des possibilités de dialoguer entre les diverses parties prenantes sur les significations et les implications des résultats et des affirmations de l’évaluation. Tout en reconnaissant que la conduite de cette évaluation a été très compliquée, le fait d’avoir été explicite sur l’engagement « pluraliste et démocratique » de l’équipe d’évaluation a permis de produire des jugements justes et impartiaux non pas parce qu’ils étaient objectifs, mais parce qu'ils reflétaient des intérêts multiples et notamment celui des étudiant·es.

Ajoutons ici que pour Greene, la défense du pluralisme dans les évaluations peut et doit se faire avant tout au service de ce que l’on entend le moins, et qui sont souvent les bénéficiaires, in fine, des politiques publiques :

Les évaluateurs doivent aujourd'hui faire des efforts particuliers pour rechercher et inclure les voix et les points de vue qui sont souvent négligés ou exclus de la conversation évaluative - parce qu'ils ne sont pas invités, parce que leurs opinions sont impopulaires, ou parce qu'ils n'ont pas la langue ou la fluidité verbale nécessaires pour être entendus.

Cette position est depuis devenue largement partagée dans la communauté évaluative en Amérique du Nord, notamment à travers les travaux de Donna Mertens à qui nous donnions la parole dans une interview récente lors de son passage en France.

Greene, J. (1997) Evaluation as advocacy. Evaluation Practice, Volume: 18 issue: 1, page(s): 25-35 doi

Ce numéro 1 a été préparé par Adrien Flichy, Marc Tevini, Alexandra Williams et Thomas Delahais avec le soutien d'Hélène Faure. Relire le nº0. Pour vous abonner, cliquez ici (4 numéros par an).

Markus Palenberg est un évaluateur, il travaille principalement dans le champ des programmes mondiaux de développement international. Arne Paulson est un économiste du développement. Il a fait l'essentiel de sa carrière dans des institutions internationales, dont la Banque mondiale. ↩

Olaf Rieper est un évaluateur danois. ↩

Sebastian Lemire est un évaluateur et chercheur danois, il travaille notamment sur les évaluations basées sur la théorie. Christina Christie est une chercheuse américaine, elle travaille notamment sur la théorie évaluative. Steffen Bohni Nielsen a longtemps été consultant en secteur public au Danemark, il officie maintenant en collectivité. ↩

R. Pablo Guerrero est le Directeur Réseau de la Global Initiative for Fiscal Transparency. ↩

mercredi 15 janvier 2025

How transitions change evaluations, and how evaluations can help transitionss

mercredi 15 janvier 2025

How transitions change evaluations, and how evaluations can help transitionss

mardi 09 juillet 2024

Les programmes d'innovation se multiplient, mais sans jamais être évalués

mardi 11 juin 2024

Et si on partait des usages de la connaissance plutôt que de la production d'évaluations ?

mercredi 05 juin 2024

Un nouveau livre sur les théories du changement en évaluation

mardi 23 avril 2024

Une présentation réalisée dans le cadre de Design des politiques publiques nouvelle génération 2024

lundi 08 avril 2024

Texte rédigé dans le cadre du MOOC de l'Université Paris 1

lundi 23 octobre 2023

Evaluating EU Cohesion policy — European Court of Auditors

lundi 03 juillet 2023

The challenges of external validity, towards an interdisciplinary discussion?

mardi 27 juin 2023

Les défis de la validité externe, un sujet d'échange interdisciplinaire ?

vendredi 16 juin 2023

Le name and shame est-il une politique publique efficace?

jeudi 19 janvier 2023

Quelles distinctions entre l'évaluation et les pratiques voisines ?

mardi 01 novembre 2022

Quelle démarche pour une cartographie des usages de l'évaluation d'impact ?

samedi 15 octobre 2022

Un numéro très très lutte – pour l'équité raciale, entre objectivistes et subjectivistes, et oldies but goodies pour faire entendre l'évaluation dans un contexte politisé.

dimanche 17 juillet 2022

Feedback on the European Evaluation Society Conference in Copenhagen

mardi 12 juillet 2022

Retour sur la conférence de la société européenne d'évaluation à Copenhague

mercredi 15 juin 2022

Dans ce numéro, cinéma à tous les étages : La Revanche des Sith, Octobre rouge et 120 battements par minute... ou presque

vendredi 25 mars 2022

Publication

mardi 15 mars 2022

Dans ce numéro, la cartographie des controverses rencontre la science comportementale, et la recherche l'action publique.

mercredi 15 décembre 2021

Numéro spécial Anthologie

lundi 20 septembre 2021

Des citations inspirantes pour qui évalue.

mercredi 15 septembre 2021

Dans ce numéro, évaluation et bureaucratie, l'ultime combat, enquêter avec d'autres êtres, et oldiesbutgoodies, on sauve le monde avec Bob Stake !

vendredi 09 juillet 2021

Oldies but goodies (Karine Sage)

samedi 15 mai 2021

Dans ce numéro, des échecs, des échecs, des échecs, l'évaluation pleinement décrite et pleinement jugée et la réception des politiques du handicap. Pas de oldiesbutgoodies, mais ça reviendra pour le numéro 4 !

jeudi 29 avril 2021

Nouvel article publié (Thomas Delahais)

mardi 27 avril 2021

À l'occasion de la sortie de Strateval, nous revenons sur 3 autres jeux de cartes autour de l'évaluation

jeudi 08 avril 2021

Nouvel article publié (Marc Tevini)

lundi 15 février 2021

Dans ce numéro, évaluation féministe quésaco, apprentissage et redevabilité même combat ? et oldiesbutgoodies, des éléments pour une sociologie de l'évaluation... C'est le sommaire de ce numéro 2.

vendredi 15 janvier 2021

Introduction au séminaire de l'IRTS HDF du 26/01.

mardi 15 décembre 2020

Introduction à la formation à l'analyse de contribution

dimanche 15 novembre 2020

Dans ce numéro, plongée en pleine guerre froide avec la Realpolitik de l'évaluation, des idées pour professionnaliser l'évaluation, et oldiesbutgoodies, de quoi se demander ce que les évaluateurs et les évaluatrices défendent dans leur métier... C'est le sommaire de ce numéro 1.

lundi 09 novembre 2020

Intervention de T Delahais au Congrès de la SEVAL organisé par le GREVAL à Fribourg, le 4 septembre 2020.

jeudi 29 octobre 2020

Contribution de T Delahais et M Tevini en réponse à l'appel de la SFE, "Ce que la crise sanitaire nous apprend sur l'utilité et les pratiques d'évaluation".

vendredi 23 octobre 2020

Nouvel article publié (Thomas Delahais, Karine Sage, Vincent Honoré)

mardi 06 octobre 2020

Nouvel article publié (Agathe Devaux-Spatarakis)

jeudi 30 juillet 2020

À l'honneur pour cette édition, la sagesse pratique des évaluateurs et des évaluatrices, soit « la capacité de faire les bons choix, au bon moment, pour les bonnes raisons » ; ce que les mots et concepts de l'évaluation perdent et gagnent à leur traduction d'une langue à l'autre et oldies but goodies, une piqûre de rappel quant à la vocation démocratique de l'évaluation en France... C'est le sommaire de ce numéro 0.